Близько 58% українців використовують інструменти штучного інтелекту (ШІ), таку цифру оприлюднили в компанії Rakuten Viber. Звичайно, ці цифри можуть бути приблизними, адже компанія не є соціологічною, а опитування провела серед своїх користувачів. Втім, інструменти ШІ наскільки міцно інтегруються в наше буденне життя, що користувачі одружуються зі своїми асистентами ШІ, генерують передсмертні записки, створюють духовні пари з ботами ШІ, та й редакції не відстають, навіть генерують віртуальних ведучих для озвучення новин.

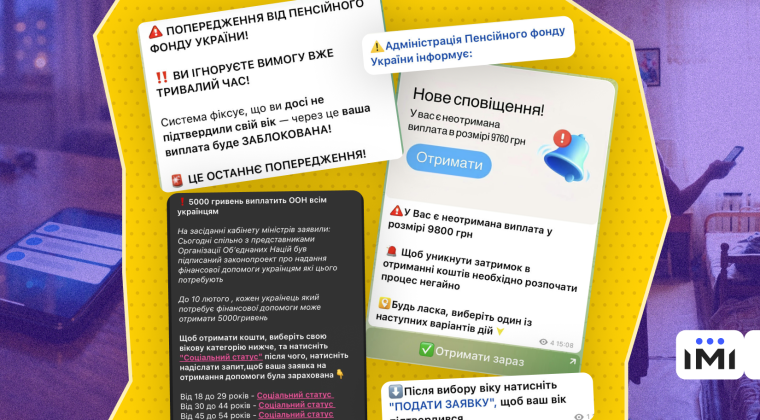

(Не)маркування, баги та етика. ШІ в руках редакцій

За даними Нацради, у жовтні 2025 року близько 42% українських редакцій у своїй роботі використовували ШІ. Для порівняння: у 2024 році експерти ІМІ опитали українських журналістів, і тоді лише близько 22% редакцій повідомили, що залучають інструменти ШІ у своїй роботі.

Наявність ШІ в редакційних процесах не завжди означає, що такі інструменти використовують етично, як це описано в редакційній політиці. За спостереженнями ІМІ, частина редакцій декларує те, як вони працюють з контентом за допомогою ШІ, але більшість редакцій залучає ШІ мовчки.

Один з таких прикладів – практика редакції ТСН. Редакція генерує зображення до матеріалів за допомогою Gemini, однак не маркує під картинкою, що зображення згенероване ШІ.

Скриншот матеріалу на сайті ТСН з водяним знаком Gemini

Трапляються випадки, коли редакції логотип Gemini обрізають. Але окремі елементи логотипа все ще залишаються помітними, що дозволяє ідентифікувати походження таких зображень.

Скриншот матеріалу на сайті ТСН з обрізаним водяним знаком Gemini

Важливим також є те, що в редакційній політиці не прописано положень про використання штучного інтелекту в роботі з контентом. У такому разі аудиторія не зможе зрозуміти, чи справжнє фото, ілюстрація, чи згенерована картинка.

До прикладу, в редакції “Еспресо” також не прописано правил використання ШІ в редполітиці, втім журналісти прозоро маркують зображення, створені за допомогою ШІ.

Скриншот матеріалу “Еспресо” з належним маркуванням контенту, створеного за допомогою ШІ

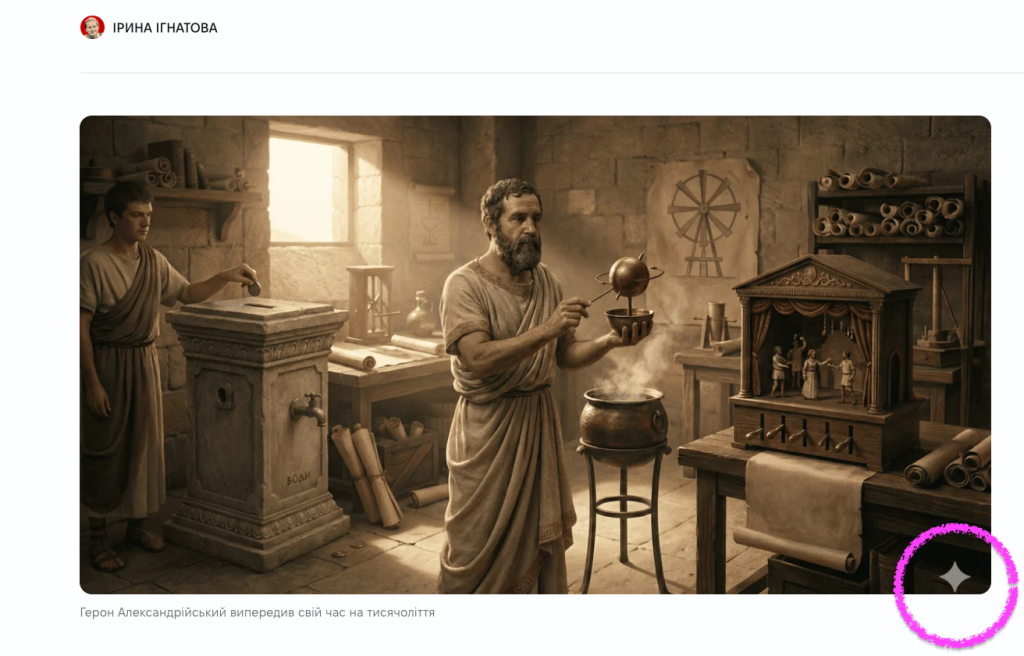

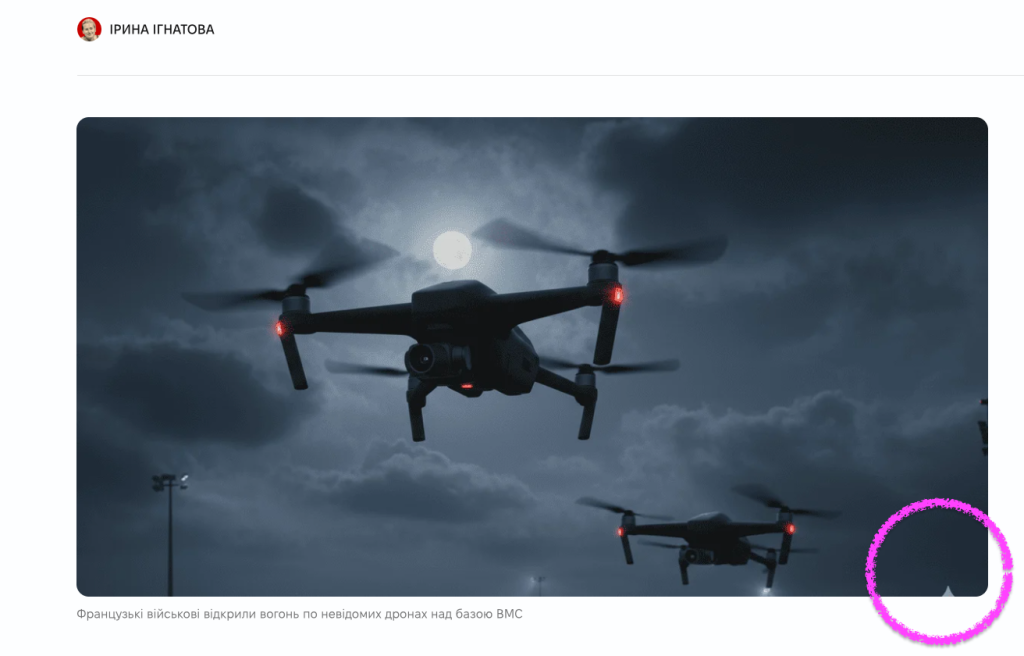

Ще з цікавого: редакція ZN,ua опублікувала матеріал про ШІ з експертом, який сам нагенерував візуальний контент для матеріалу, і його ж ім’ям підписали графічні елементи. Така прозора ідентифікація та маркування згенерованих зображень відповідає журналістським стандартам та є зрозумілою для читачів.

Скриншот матеріалу ZN,ua з маркуванням контенту, створеного ШІ

Водночас наявність прописаних політик використання ШІ не гарантує, що ці інструменти не підведуть у роботі. До прикладу, в редакції NV прописано політику маркування згенерованого контенту, і вони дійсно добре маркують. Водночас інструменти ШІ можуть створювати візуальні неточності, або так звані глюки, які не завжди очевидні на етапі публікації.

Скриншот матеріалу із сайту NV, створеного за допомогою ШІ

У цьому разі зображення містить візуальний елемент, що не відповідає реальності, бо в природі гриби не є складником брюссельської капусти. Подібні візуальні глюки можуть викликати в частини аудиторії сумніви щодо достовірності матеріалу загалом.

“GPT сказав” vs “GPT проаналізував”

За спостереженнями Інституту масової інформації, штучний інтелект дедалі частіше стає проміжною ланкою між журналістським матеріалом і аудиторією. І застосовується вже не як внутрішній редакційний інструмент, а як зовнішній інтерпретатор змісту. Це змінює саму модель споживання новин і створює нові ризики для відповідальності, довіри та навіть економічної стійкості медіа.

Минулого року низка національних онлайн-медіа експериментувала з інтеграцією функцій на кшталт кнопки “Зробити резюме статті: ChatGPT”. Такий інструмент дозволяв читачеві в один клік перейти з матеріалу на сторонню платформу зі вже сформованим запитом для аналізу тексту. Фактично аудиторії пропонували не журналістський продукт редакції, а згенеровану інтерпретацію, створену поза межами медіа та поза його редакційною відповідальністю.

Згодом більшість таких експериментів була припинена. Це рішення видається логічним з огляду на ризики, які супроводжують подібні практики. По-перше, редакція фактично втрачає контроль над трактуванням власного матеріалу, бо ШІ може продукувати спотворені висновки, помилки або навіть фейкові твердження, за які медіа не здатне відповідати ані юридично, ані репутаційно. І водночас медіа буде асоціюватися з такими фейковими твердженнями.

По-друге, така модель напряму шкодить показникам залученості. Коли читач переходить за межі сайту, час перебування на сторінці не зараховується, знижується глибина перегляду та цінність аудиторії для рекламодавців. У цьому разі штучний інтелект перестає бути допоміжним інструментом і перетворюється на прямого конкурента за увагу читача.

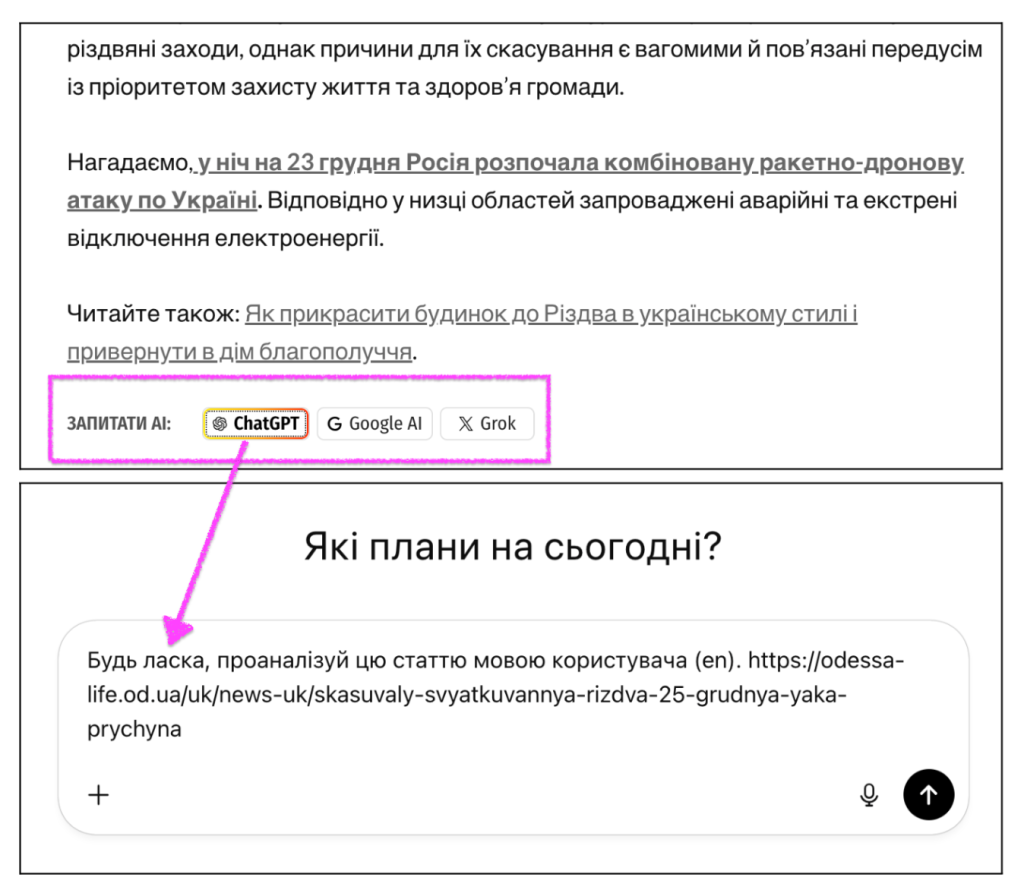

Окрім національних медіа, схожий інструмент можна побачити в регіональних. Зокрема, на сайті “Одеське життя” аналітики ІМІ фіксують, що кнопка “Запитати AI”, пропонує читачеві обрати одну з кількох платформ: ChatGPT, Google AI та Grok.

Колаж ІМІ. Зображено сторінку “Одеське життя” та GPT з авторським промтом від “Одеського життя”

Цей функціонал має певні відмінності, бо кнопка розміщена наприкінці тексту й активується після його прочитання, а також застосовується до широкого кола новинних матеріалів. Утім, базовий принцип залишається незмінним, читача переправляють за межі сайту для споживання згенерованого контенту.

Для регіональних медіа така практика є особливо ризикованою. В умовах повномасштабної війни рекламний ринок суттєво скоротився, а припинення або зменшення міжнародної грантової підтримки зробило час і увагу аудиторії критично важливим ресурсом. Передаючи фінальне споживання контенту стороннім AI-платформам, редакції фактично відмовляються від власної конкурентної переваги – довіри, залученості та прямого контакту з читачем.

Програма “Чат GPT” сказала…

Окремої уваги заслуговують випадки, коли штучний інтелект з’являється в медіа не як інструмент чи технології, а як поінформоване джерело. Схоже, деякі редакції використовують його замість пошуку в гуглі.

У цих двох прикладах редакції використали формулювання, які мають ознаки автоматичного переписування тексту. На думку аналітиків ІМІ, обидва заголовки мають ознаки того, що вони опубліковані без фінального редакторського вичитування. Так трапляється, коли редакції хочуть за допомогою ШІ зробити рерайт SEO-заголовка, втім ловлять змістовий глюк, який мав би бути помічений та вичитаний живою людиною, що є відповідальною за контент у стрічці новин.

Що далі?

Розвиток медіа неминуче буде тісно пов’язаний із ШІ. Відмовлятися від його використання не варто, але варто вчитися його правильно використовувати.

Наведені вище приклади з національних і регіональних медіа показують, що ключовим викликом стає не саме використання штучного інтелекту, а відсутність чітких правил і редакторського контролю за ним. У провідних світових редакціях ШІ дедалі частіше розглядають не як заміну журналіста, а як інструмент, який потребує окремого вичитування й окремого рівня відповідальності.

Фактично йдеться про появу нової редакторської функції, нового співробітника редакції, відповідального за перевірку та контроль контенту, створеного або обробленого за допомогою ШІ. Така практика вже застосовується в низці міжнародних медіа, бо ШІ вже активно використовують для чернеток, перекладів, резюме або роботи з даними.

Особливу увагу варто також приділяти стилю. Якщо аудиторія дедалі частіше помічатиме шаблонність, вторинність або втрату авторського голосу, це буде безпосередньо впливати на довіру й готовність взаємодіяти з медіа.

За будь-яких технологічних експериментів відповідальність за контент, опублікований на сайті, має залишатися за редакцією. І саме це має бути відправною точкою для рішень щодо впровадження ШІ.